Attraverso i commenti del blog, un nostro caro lettore ci ha fatto una domanda, a suo dire, apparentemente molto semplice ma che, come potete verificare molto facilmente, genera tantissima confusione. In sintesi la domanda e’ questa: perche’ si dice che volare in aereo e’ cosi sicuro?

Per poter rispondere a questa domanda, si devono ovviamente scartabellare i numeri ufficiali degli incidenti aerei. Questo ci consente di poter verificare la probabilita’ di un incidente aereo rapportato, ad esempio, a quelli ben piu’ noti automobilistici. Partendo da questa domanda, mi sono pero’ chiesto qualcosa in piu’: sappiamo veramente perche’ gli aerei riescono a volare? Anche questa potrebbe sembrare una domanda molto semplice. Si tratta di una tecnologia conosciuta da diversi decenni eppure, incredibile ma vero, non tutti sanno perche’ questi enormi oggetti riescono a stare in aria. Facendo un giro su internet, ho scoperto come anche molti siti di divulgazione della scienza fanno delle omissioni o dicono cose formalmente sbagliate.

Detto questo, credo sia interessante affrontare un discorso piu’ ampio prima di poter arrivare a rispondere alla domanda sugli incidenti aerei.

Partiamo dalle basi, come sapete ruolo fondamentale nel volo aereo e’ quello delle ali. Mentre il motore spinge in avanti l’apparecchio, le ali hanno la funzione di far volare l’aereo. Ora, per poter restare in quota, o meglio per salire, senza dover parlare di fisica avanzata, c’e’ bisogno di una forza che spinga l’aereo verso l’alto e che sia maggiore, o al limite uguale per rimanere alle stessa altezza, del peso dell’aereo stesso.

Come fanno le ali ad offrire questa spinta verso l’alto?

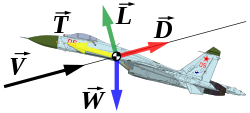

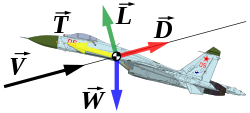

Forze agenti sull’ala durante il volo

Tutto il gioco sta nel considerare l’aria che scorre intorno all’ala. Vediamo la figura a lato per capire meglio. L’aria arriva con una certa velocita’ sull’ala, attenzione questo non significa che c’e’ vento con questa velocita’ ma, pensando al moto relativo dell’aereo rispetto al suolo, questa e’ in prima approssimazione la velocita’ stessa con cui si sta spostando l’aereo. Abbiamo poi il peso dell’aereo che ovviamente e’ rappresentato da una forza che spinge verso il basso. D e’ invece la resistenza offerta dall’ala. Vettorialmente, si stabilisce una forza L, detta “portanza”, che spinge l’aereo verso l’alto.

Perche’ si ha questa forza?

Come anticipato, il segreto e’ nell’ala, per la precisione nel profilo che viene adottato per questa parte dell’aereo. Se provate a leggere la maggiorparte dei siti divulgativi, troverete scritto che la forza di portanza e’ dovuta al teorema di Bernoulli e alla differenza di velocita’ tra l’aria che scorre sopra e sotto l’ala. Che significa? Semplicemente, l’ala ha una forma diversa nella parte superiore, convessa, e inferiore, quasi piatta. Mentre l’aereo si sposta taglia, come si suole dire, l’aria che verra’ spinta sopra e sotto. La differenza di forma fa si che l’aria scorra piu’ velocemente sopra che sotto. Questo implica una pressione maggiore nella parte inferiore e dunque una spinta verso l’alto. Per farvi capire meglio, vi mostro questa immagine:

Percorso dell’aria lungo il profilo alare

Come trovate scritto in molti siti, l’aria si divide a causa del passaggio dell’aereo in due parti. Vista la differenza di percorso tra sopra e sotto, affinche’ l’aria possa ricongiungersi alla fine dell’ala, il fluido che scorre nella parte superiore avra’ una velocita’ maggiore. Questo crea, per il teorema di Bernoulli, la differenza di pressione e quindi la forza verso l’alto che fa salire l’aereo.

Spiegazione elegante, semplice, comprensibile ma, purtroppo, fortemente incompleta.

Perche’ dico questo?

Proviamo a ragionare. Tutti sappiamo come vola un aereo. Ora, anche se gli aerei di linea non lo fanno per ovvi motivi, esistono apparecchi acrobatici che possono volare a testa in giu’. Se fosse vero il discorso fatto, il profilo dell’ala in questo caso fornirebbe una spinta verso il basso e sarebbe impossibile rimanere in aria.

Cosa c’e’ di sbagliato?

In realta’ non e’ giusto parlare di spiegazione sbagliata ma piuttosto bisogna dire che quella data e’ fortemente semplificata e presenta, molto banalmente come visto, controesempi in cui non e’ applicabile.

Ripensiamo a quanto detto: l’aria scorre sopra e sotto a velocita’ diversa e crea la differenza di pressione. Chi ci dice pero’ che l’aria passi cosi’ linearmente lungo l’ala? Ma, soprattutto, perche’ l’aria dovrebbe rimanere incollata all’ala lungo tutto il percorso?

La risposta a queste domande ci porta alla reale spiegazione del volo aereo.

L’effetto Coanda sperimentato con un cucchiaino

Prima di tutto, per capire perche’ l’aria rimane attaccata si deve considerare il profilo aerodinamico e il cosiddetto effetto Coanda. Senza entrare troppo nella fisica, questo effetto puo’ semplicemente essere visualizzato mettendo un cucchiaino sotto un lieve flusso d’acqua. Come sappiamo bene, si verifica quello che e’ riportato in figura. L’acqua, che cosi’ come l’aria e’ un fluido, scorre fino ad un certo punto lungo il profilo del metallo per poi uscirne. Questo e’ l’effetto Coanda ed e’ quello che fa si che l’aria scorra lungo il profilo alare. Questo pero’ non e’ ancora sufficiente.

Nella spiegazione del volo utilizzando il teorema di Bernoulli, si suppone che il moto dell’aria lungo l’ala sia laminare, cioe’, detto in modo improprio, “lineare” lungo l’ala. In realta’ questo non e’ vero, anzi, un moto turbolento, soprattutto nella parte superiore, consente all’aria di rimanere maggiormente attaccata evitando cosi’ lo stallo, cioe’ il distaccamento e la successiva diminuzione della spinta di portanza verso l’alto.

In realta’, quello che avviene e’ che il moto dell’aria lungo il profilo compie una traiettoria estremamente complicata e che puo’ essere descritta attraverso le cosiddette equazioni di Navier-Stokes. Bene, allora scriviamo queste equazioni, risolviamole e capiamo come si determina la portanza. Semplice a dire, quasi impossibile da fare in molti sistemi.

Cosa significa?

Le equazioni di Navier-Stokes, che determinano il moto dei fluidi, sono estremamente complicate e nella maggior parte dei casi non risolvibili esattamente. Aspettate un attimo, abbiamo appena affermato che un aereo vola grazie a delle equazioni che non sappiamo risolvere? Allora ha ragione il lettore nel chiedere se e’ veramente sicuro viaggiare in aereo, praticamente stiamo dicendo che vola ma non sappiamo il perche’!

Ovviamente le cose non stanno cosi’, se non in parte. Dal punto di vista matematico e’ impossibile risolvere “esattamente” le equazioni di Navier-Stokes ma possiamo fare delle semplificazioni aiutandoci con la pratica. Per poter risolvere anche in modo approssimato queste equazioni e’ necessario disporre di computer molto potenti in grado di implementare approssimazioni successive. Un grande aiuto viene dalla sperimentazione che ci consente di determinare parametri e semplificare cosi’ la trattazione matematica. Proprio in virtu’ di questo, diviene fondamentale la galleria del vento in cui vengono provati i diversi profili alari. Senza queste prove sperimentali, sarebbe impossibile determinare matematicamente il moto dell’aria intorno al profilo scelto.

In soldoni, e senza entrare nella trattazione formale, quello che avviene e’ il cosiddetto “downwash” dell’aria. Quando il fluido passa sotto l’ala, viene spinto verso il basso determinando una forza verso l’alto dell’aereo. Se volete, questo e’ esattamente lo stesso effetto che consente agli elicotteri di volare. In quest’ultimo caso pero’, il downwash e’ determinato direttamente dal moto dell’elica.

Detto questo, abbiamo capito come un aereo riesce a volare. Come visto, il profilo dell’ala e’ un parametro molto importante e, ovviamente, non viene scelto in base ai gusti personali, ma in base ai parametri fisici del velivolo e del tipo di volo da effettuare. In particolare, per poter mordere meglio l’aria, piccoli velivoli lenti hanno ali perfettamente ortogonali alla fusoliera. Aerei di linea piu’ grandi hanno ali con angoli maggiori. Al contrario, come sappiamo bene, esistono caccia militari pensati per il volo supersonico che possono variare l’angolo dell’ala. Il motivo di questo e’ semplice, durante il decollo, l’atterraggio o a velocita’ minori, un’ala ortogonale offre meno resitenza. Al contrario, in prossimita’ della velocita’ del suono, avere ali piu’ angolate consente di ridurre al minimo l’attrito viscoso del fluido.

Ultimo appunto, i flap e le altre variazioni di superficie dell’ala servono proprio ad aumentare, diminuire o modificare intensita’ e direzione della portanza dell’aereo. Come sappiamo, e come e’ facile immaginare alla luce della spiegazione data, molto importante e’ il ruolo di questi dispositivi nelle fasi di decollo, atterraggio o cambio quota di un aereo.

In soldoni dunque, e senza entrare in inutili quanto disarmanti dettagli matematici, queste sono le basi del volo.

Detto questo, cerchiamo di capire quanto e’ sicuro volare. Sicuramente, e come anticipato all’inizio dell’articolo, avrete gia’ sentito molte volte dire: l’aereo e’ piu’ sicuro della macchina. Questo e’ ovviamente vero, se consideriamo il numero di incidenti aerei all’anno questo e’ infinitamente minore di quello degli incidenti automobilistici. Ovviamente, nel secondo caso mi sto riferendo solo ai casi mortali.

Cerchiamo di dare qualche numero. In questo caso ci viene in aiuto wikipedia con una pagina dedicata proprio alle statistiche degli incidenti aerei:

– Wiki, incidenti aerei

Come potete leggere, in media negli ultimi anni ci sono stati circa 25 incidenti aerei all’anno, che corrispondono approssimativamente ad un migliaio di vittime. Questo numero puo’ oscillare anche del 50%, come nel caso del 2005 in cui ci sono state 1454 vittime o nel 2001 in cui gli attentati delle torri gemelle hanno fatto salire il numero. La maggiorparte degli incidenti aerei sono avvenuti in condizioni di meteo molto particolari o in fase di atterraggio. Nel 75% degli incidenti avvenuti in questa fase, gli aerei coinvolti non erano dotati di un sistema GPWS, cioe’ di un sistema di controllo elettronico di prossimita’ al suolo. Cosa significa? Un normale GPS fornisce la posizione in funzione di latitudine e longitudine. Poiche’ siamo nello spazio, manca dunque una coordinata, cioe’ la quota a cui l’oggetto monitorato si trova. Il compito del GPWS e’ proprio quello di fornire un sistema di allarme se la distanza dal suolo scende sotto un certo valore. La statistica del 75% e’ relativa agli incidenti avvenuti tra il 1988 e il 1994. Oggi, la maggior parte degli aerei civili e’ dotato di questo sistema.

Solo per concludere, sempre in termini statistici, e’ interessante ragionare, in caso di incidente, quali siano i posti lungo la fusoliera piu’ sicuri. Attenzione, prendete ovviamente questi numeri con le pinze. Se pensiamo ad un aereo che esplode in volo o che precipita da alta quota, e’ quasi assurdo pensare a posti “piu’ sicuri”. Detto questo, le statistiche sugli incidenti offrono anche una distribuzione delle probabilita’ di sopravvivenza per i vari posti dell’aereo.

Guardiamo questa immagine:

Statistiche della probabilita’ di sopravvivenza in caso di incidente aereo

Come vedete, i posti piu’ sicuri sono quelli a prua, cioe’ quelli piu’ vicini alla cabina di pilotaggio ma esiste anche una distribuzione con picco di sicurezza nelle file centrali vicino alle uscite di emergenza. Dal momento che, ovviamente in modo grottesco, i posti a prua sono quelli della prima classe, il fatto di avere posti sicuri anche dietro consente di offrire una minima ancora di salvataggio anche ad i passeggeri della classe economica.

Concudendo, abbiamo visto come un aereo riesce a volare. Parlare solo ed esclusivamente di Bernoulli e’ molto riduttivo anche se consente di capire intuitivamente il principio del volo. Questa assunzione pero’, presenta dei casi molto comuni in cui non e’ applicabile. Per quanto riguarda le statistiche degli incidenti, l’aereo resta uno dei mezzi piu’ sicuri soprattutto se viene confrontato con l’automobile. Come visto, ci sono poi dei posti che, per via della struttura ingegneristica dell’aereo, risultano statisticamente piu’ sicuri con una maggiore probabilita’ di sopravvivena in caso di incidente.

”Psicosi 2012. Le risposte della scienza”, un libro di divulgazione della scienza accessibile a tutti e scritto per tutti. Matteo Martini, Armando Curcio Editore.

Tag:acqua, acrobatici, acrobazie, aerei, aereo, aeroplano, ala, alare, ali, allarme, altezza, alto, angolazione, angolo, anno, apparecchio, applicabile, applicabilita', approssimato, approssimazione, approssimazioni, aria, asse, atmosferico, attacco, atterraggio, attrito, auto, automobile, avanti, aviazione, barriera, basi, basso, bernoulli, cabina, capovolti, capovolto, civile, classe, coanda, coda, come, componenti, condizioni, confronto, considerazioni, controesempi, controllo, cucchiaino, dati, decollo, differenza, differenza di pressione, diminuzione, direzione, discesa, distacco, divisione, divulgazione, downwash, economica, economy, elettronico, elica, elicottero, enav, equazione, equazioni, errore, esatta, esempi, estensori, fisica, flap, fluidi, fluido, flusso, forma, forza, funziona, fusoliera, galleria, gpws, incidenti, incollata, inferiore, laminare, limiti, lungo, macchina, maggiormente, matematica, meteo, mezzi, migliore, morde, mortali, morte, morti, motivo, moto, motore, motori, navier, navier stokes, numero, pale, perche', peso, portanza, portata, posti, posto, potenza, pressione, pressioni, prevenzione, prima, principio, probabilita', profilo, prossimita, prove, quota, raccolta, resistenza, reynolds, ricongiunge, rotore, ruolo, salire, salita, sapere, sbagiato, scelta, scienza, scorre, sedile, semplice, semplici, sicurezza, sicuri, sicuro, sistema, soluzione, sopra, sotto, sperimentale, sperimentazione, spiegazione, spinta, stacca, stallo, statistiche, stokes, suono, superiore, supersonici, taglia, temperatura, teorema, teoria, traiettoria, turbolento, velicolo, velocita', vento, viaggio, viscoso, volare, volo, volo aereo

Il Bloggatore

Il Bloggatore

Commenti recenti